As

tecnologias Flash e a virtualização das aplicações de nível um estão agitando o

mundo corporativo.

Por

George Teixeira, Presidente e CEO da DataCore Software

Durante

o 2012, vimos os primeiros passos em uma tentativa de definir as arquitecturas

do software de armazenagem. Isso provocou uma serie de tendências cruciais que

estão remodelando e que tem um importante impacto no mundo da armazenagem

empresarial, preparando o cenário do ano 2013 para que converta-se no ano em

que a armazenagem baseada em software mudará os Datacenters.

A

mudança do hardware para um modelo baseado em um software de

virtualização, apoia as missões cruciais

das aplicações do negócio que mudou a criação da arquitectura dos computadores, redes e dos

níveis de armazenagem, passando de ser “estáticas” a “dinâmicas”. O Software

define as bases da agilidade, interacção dos usuários e a construção de uma infra-estrutura

virtual a longo prazo, que se adapta as mudanças. O objectivo final é aumentar

a produtividade do usuário e melhorar a experiencia da aplicação.

Tendência #1: As aplicações nivel 1 virtualizão-se e o

rendimento é crucial

Os esforços para virtualizar ainda mais o data center continuam,

e vemos um aumento ainda maior da mobilização das aplicações de nível 1 (ERP,

databases, sistemas de e-mail, OLTP etc.) em direção às plataformas de virtualização. Os factores chaves que

impulsarão esta mudança são os económicos, assim como a obtenção de uma melhor

produtividade.

Sin embargo, os principais obstáculos para a

virtualização das aplicações de nível 1 estão em grande medida relacionadas com

a armazenagem.

Transferir o armazenamento intensivo das cargas de

trabalho para máquinas virtuais (VMs) pode ser de grande impacto para o

rendimento e a disponibilidade. Por tanto, o armazenamento deve ser

sobre-abastecido e de grande tamanho. Além do que, a medida que o negocio se

consolida nas plataformas virtuais, devem gastar mais para alcançar os altos

níveis de redundância e continuidade do negocio; sem contar com as preocupações

relacionadas com o rendimento e os engarrafamentos.

Os altos custos e a complexidade da sobre dimensão

eliminam os benefícios e põe o armazenamento em um túnel sem saída. Com estos pontos em mente, as empresas e os departamentos IT buscam um enfoque mais

inteligente, com uns custos mais rentáveis, ao dar-se conta de que acrescentar

“mais hardware ao problema” não é a

solução mais prática.

Tendência #2: As tecnologias SSD flash serão utilizadas

em qualquer lugar, o armazenamento não é somente para os dispositivos de

disco

Outra grande tendência relacionada

com a virtualização das aplicações de nível 1 é a proliferação das tecnologias

baseadas em SSD flash. A razão é simples, os discos de armazenamento são

dispositivos mecânicos de rotação e não tão agis como aqueles baseados em

memorias electrónicas de alta velocidade.

As memorias flash estiveram ao

nosso arredor durante anos, ao princípio eram uma solução excessivamente cara

para a sua adopção. Mesmo assim, são mais custosas que a rotação dos

dispositivos hardware, seu uso massivo em tablets e celulares estão conduzindo

a abaixar o seu precio. Inclusive assim, a tecnologia flash desgasta-se, e um uso continuado devido a que as aplicações que

se reescrevem continuamente podem impactar na sua vida útil.

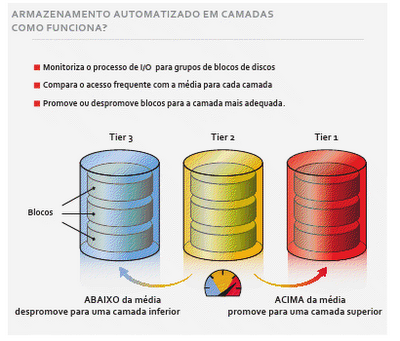

Se os dispositivos flash são

uma parte inevitável do nosso futuro e necessitam ser incorporados na nossa

visão da arquitectura futura, a economia nos conduz a um mundo que precisa de

diferentes níveis de armazenagem, baseados em memorias menos caras e direccionada a discos menos

lentos. Isto, porém, aumenta a demanda das empresas em quanto a utilização de

um software de auto-tiering, capaz de optimizar o rendimento a um preço atractivo através da mudança de datos

com uma solução do nível mais rentável, que proporcione ao mesmo tempo um rendimento aceitável.

Tendência #3: Mais armazenagem requer mais

automatização

Existe uma demanda constante e

insaciável que requer mais capacidade de armazenagem de datos, esta demanda

segue crescendo mais de 50 por cento ao ano. Porém, a necessidade não se

concentra unicamente em mais discos hardware para satisfazer a capacidade neta. Em seu lugar, os usuários querem

automatização, gestão automática de armazenagem, escalabilidade, provisões

rápidas, grande rendimento, e mais altos níveis de continuidade do negocio.

Uma vez mais, necessita-se um

“software inteligente” para simplificar e automatizar a gestão da armazenagem.

Tendência

#4: A definição da arquitectura do software de armazenagem importará mais que o

hardware

Essas tendências – e melhoras TI para os usuários, fazem

com que a armazenagem hardware seja

intercambiáveis com infra-estruturas virtuais – teremos um profundo

impacto sobre como pensamos, compramos e

utilizamos o armazenamento. Em 2013 em diante, as tecnologias TI necessitarão

incorporar o software de armazenagem definitivamente como um elemento essencial

dos data centers.

Devido a que os usuários TI das companhias actuais estão

acostumadas a rápida e dinâmica sociedade actual, não podem ver-se presos em

arquitecturas rígidas de hardware por cabo. A infra-estrutura se constrói sobre

três pilares: computação, redes e armazenamento – e em cada uma de elas, as

decisões relacionadas com o hardware serão secundarias e virão ditadas pelo

software e impulsodas pelas aplicações.

É evidente que o grande sucesso de VMware y Microsoft

Híper demonstram que a virtualização dos servidores oferecem um valor

convincente. Da mesma forma que a armazenagem hipervisor e a virtualização a

nível de armazenamento, são fundamentais para desbloquear as cadeias do

hardware que foram uma âncora para a armazenagem da próxima geração dos centros de datos.

Tendência #5: A definição da arquitectura do

software de armazenagem cria a

necessidade de um hipervisor de armazenagem

O

mesmo pensamento que mudou nossos pontos de vista sobre o provedor, é

necessário para redireccionar a armazenagem; e o software inteligente é o catalisador.

Em resumem, o papel principal do hipervisor de armazenagem é virtualizar os

recursos de armazenagem para conseguir os mesmos benefícios - agilidade,

eficiência e flexibilidade – características que proporcionam a tecnologia do

híper visor aos processadores e memorias.

Este

ano, o software pegará seu correcto lugar na mesa e começarão

a transformar nossa visão sobre a armazenagem.

O objectivo final: Uma melhor experiencia através da aplicação definida

pelo software de armazenagem.

A virtualização mudou a informática e as

aplicações que dependemos para administrar os nossos negócios. Ainda assim, o

armazenamento empresarial e a nuvem estão dominados pela mentalidade física, e

definidos pelo hardware. Temos que mudar nossa forma de pensar e considerar

como a armazenagem afecta a experiência da aplicação e ver como a armazenagem

definida pelo software, com serviços de armazenagem e características

disponíveis para toda empresa e não só incrustado em um dispositivo de hardware

central.

Porquê comprar um hardware específico somente

para obter a função de um software? Porquê limitar uma função a uma única

plataforma frente ao seu uso em toda empresa? Esse é um pensamento antigo,

anterior a virtualização, assim é como a industria de servidores funcionava.

Hoje em dia, com VMware o Hyper-V, pensamos em como desdobrar as máquinas

virtuais versus "se estão executando em um sistema Dell, HP, Intel o

IBM?"

A armazenagem está passando por uma

transformação similar, no próximo ano, será o software inteligente a qual

liderará a industria hacia sua evolução, que estará definida mundialmente pelo

software.

George Teixeira é CEO e

presidente de DataCore Software. A companhia de software que actua como

plataforma de infra-estrutura para solucionar o grande problema do estancamento

da armazenagem, mediante a eliminação das iniciativas da armazenagem

relacionadas com as barreiras que fazem da virtualização um processo difícil e

caro.